Google Cloud 認定資格 – Associate Cloud Engineer 模擬問題集(全 50 問)

QUESTION 1

HTTPS Web アプリケーションの自動スケーリング マネージド インスタンス グループを作成する必要があります。

異常な VM が再作成されていることを確認する必要があります。

どうするべきでしょうか?

- A. ポート 443 でヘルスチェックを作成し、マネージド インスタンス グループの作成時に使用します。

- B. マネージド インスタンス グループを作成する際にシングル ゾーンではなくマルチ ゾーンを選択します。

- C. インスタンス テンプレートでラベルにヘルスチェックを追加します。

- D. インスタンス テンプレートでメタデータ サーバーにハートビートを送信する起動スクリプトを追加します。

Correct Answer: A

QUESTION 2

会社にはデータウェア ハウジングに BigQuery を使用する Google Cloud Platform プロジェクトがあります。

データサイエンス チームは頻繁に変更されており、メンバーも少なくなっています。このチームのメンバーがクエリを実行できるようにする必要があります。

Google のベスト プラクティスに従うにはどうするべきでしょうか?

- A.

- 1. データサイエンティストのユーザーアカウントごとに IAM エントリを作成します。

- 2. BigQuery ジョブユーザー (roles/bigquery.jobUser) の役割をグループに割り当てます。

- B.

- 1. データサイエンティストのユーザーアカウントごとに IAM エントリを作成します。

- 2. BigQuery データ閲覧者 (roles/bigquery.dataViewer) の役割をグループに割り当てます。

- C.

- 1. CloudI dentity で専用の Google グループを作成します。

- 2.データサイエンティストのユーザーアカウントにグループを追加します。

- 3. BigQuery ジョブユーザー (roles/bigquery.jobUser) の役割をグループに割り当てます。

- D.

- 1. CloudI dentity で専用の Google グループを作成します。

- 2.データサイエンティストのユーザーアカウントにグループを追加します。

- 3. BigQuery データ閲覧者 (roles/bigquery.dataViewer) の役割をグループに割り当てます。

Correct Answer: C

Reference contents:

– #BigQuery の IAM 事前定義ロール – IAM によるアクセス制御 | BigQuery | Google Cloud

QUESTION 3

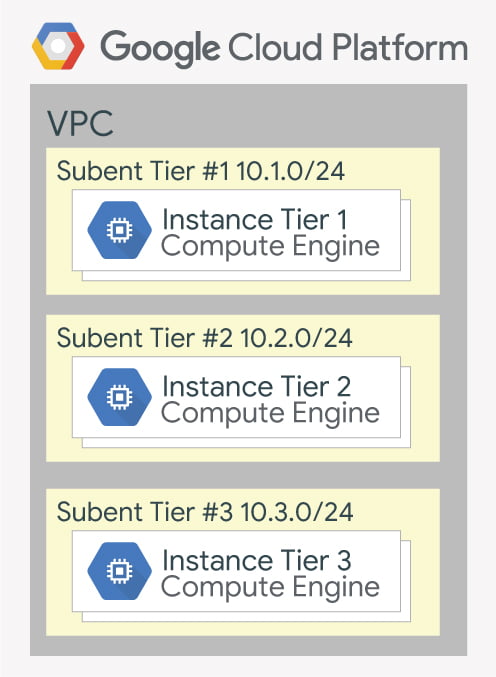

会社には Google Compute Engine で 3 レイヤーのソリューションがあります。

現在のインフラストラクチャの構成は以下のとおりです。

各レイヤーはその中のすべてのインスタンスに関連するサービス アカウントを持っています。次のようにレイヤー間の TCP ポート 8080 での通信を有効にする必要があります。

– Tier #1 インスタンスは Tier #2 と通信する必要がある

– Tier #2 インスタンスは Tier #3 と通信する必要がある

どうするべきでしょうか?

- A.

- 1. 次の設定で内向き ファイアウォール ルールを作成します。

- ターゲット:全インスタンス

- ソースフィルタ:IP 範囲(範囲を 10.0.2.0/24 に設定)

- プロトコル:すべて許可

- 2. 次の設定で内向き ファイアウォール ルールを作成します。

- ターゲット:全インスタンス

- ソースフィルタ:IP 範囲(範囲を 10.0.1.0/24 に設定)

- プロトコル:すべて許可

- 1. 次の設定で内向き ファイアウォール ルールを作成します。

- B.

- 1. 次の設定で内向き ファイアウォール ルールを作成します。

- ターゲット:Tier #2 サービス アカウントを持つ全インスタンス

- ソースフィルタ:Tier #1 サービス アカウントを持つ全インスタンス

- プロトコル:TCP 8080 を許可

- 2. 次の設定で内向き ファイアウォール ルールを作成します。

- ターゲット:Tier #3 サービス アカウントを持つ全インスタンス

- ソースフィルタ:Tier #2 サービス アカウントを持つ全インスタンス

- プロトコル:TCP 8080 を許可

- 1. 次の設定で内向き ファイアウォール ルールを作成します。

- C.

- 1. 次の設定で内向き ファイアウォール ルールを作成します。

- ターゲット:Tier #2 サービス アカウントを持つ全インスタンス

- ソースフィルタ:Tier #1 サービス アカウントを持つ全インスタンス

- プロトコル:すべて許可

- 2. 次の設定で内向き ファイアウォール ルールを作成します。

- ターゲット:Tier #3 サービス アカウントを持つ全インスタンス

- ソースフィルタ:Tier #2 サービス アカウントを持つ全インスタンス

- プロトコル:すべて許可

- 1. 次の設定で内向き ファイアウォール ルールを作成します。

- D.

- 1. 次の設定で外向き ファイアウォール ルールを作成します。

- ターゲット:全インスタンス

- ソースフィルタ:IP 範囲(範囲を 10.0.2.0/24 に設定)

- プロトコル:TCP 8080 を許可

- 2. 次の設定で外向き ファイアウォール ルールを作成します。

- ターゲット:全インスタンス

- ソースフィルタ:IP 範囲(範囲を 10.0.1.0/24 に設定)

- プロトコル:TCP 8080 を許可

- 1. 次の設定で外向き ファイアウォール ルールを作成します。

Correct Answer: B

QUESTION 4

us-central1 リージョンに単一の仮想プライベートクラウド(VPC)と単一のサブネットワークを持つプロジェクトがあります。

このサブネットワークにはアプリケーションをホストしている Google Compute Engine インスタンスがあります。europe-west1 リージョンの同じプロジェクトに新しいインスタンスをデプロイし、アプリケーションにアクセスする必要があります。

Google のベスト プラクティスに従うにはどうするべきでしょうか?

- A.

- 1. 同じ VPC の europe-west1 にサブネットワークを作成します。

- 2. 新しいサブネットワークに新しいインスタンスを作成し、最初のインスタンスのプライベートアドレスをエンドポイントとして使用します。

- B.

- 1. VPC を作成し、europe-west1 にサブネットワークを作成します。

- 2. 内部ロードバランサでアプリケーションを公開します。

- 3. 新しいサブネットワークに新しいインスタンスを作成し、エンドポイントとしてロードバランサのアドレスを使用します。

- C.

- 1. 同じ VPC 内に europe-west1 にサブネットワークを作成します。

- 2. Google Cloud VPN を使用して 2つのサブネットワークを接続します。

- 3. 新しいサブネットワークに新しいインスタンスを作成し、最初のインスタンスのプライベートアドレスをエンドポイントとして使用します。

- D.

- 1. VPC を作成し、europe-west1 にサブネットワークを作成します。

- 2. 2つの VPC をピアリングします。

- 3. 新しいサブネットワークに新しいインスタンスを作成し、最初のインスタンスのプライベートアドレスをエンドポイントとして使用します。

Correct Answer: A

QUESTION 5

先月、プロジェクトで予想以上のコストが発生しました。

調査の結果、開発用 GKE コンテナが膨大な数のログを出力しており、それがコスト増につながったことが判明しました。

最小限の手順でログを迅速に無効化するにはどうするべきでしょうか?

- A.

- 1. Stackdriver Logging の Logs ingestion ウィンドウで GKE コンテナリソースのログソースを無効化します。

- B.

- 1. Stackdriver Logging の Logs ingestion ウィンドウで GKE Cluster Operations リソースのログソースを無効にします。

- C.

- 1. GKE コンソールで既存のクラスタを削除します。

- 2. 新しいクラスタを再作成します。

- 3. Stackdriver Logging を有効にするオプションを off にします。

- D.

- 1. GKE コンソールで既存のクラスタを削除します。

- 2. 新しいクラスタを再作成します。

- 3. Stackdriver Monitoring を有効にするオプションを off にします。

Correct Answer: A

Reference contents:

– Monitored resources and services | Cloud Logging

QUESTION 6

Google App Engine スタンダード環境で Web サイトを運営しています。

ユーザーの 1%に Web サイトの新しいテストバージョンを表示してもらいたいとします。

複雑さを最小限に抑えるにはどうするべきでしょうか?

- A. 同じアプリケーションに新しいバージョンをデプロイし、-migrate オプションを使用します。

- B. 同じアプリケーションに新しいバージョンをデプロイし、-splits オプションを使用して現バージョンに 99%、新バージョンに 1% に割り当てます。

- C. 同じプロジェクトで新しい Google App Engine アプリケーションを作成します。そのアプリケーションに新しいバージョンをデプロイし、Google App Engine ライブラリを使用してリクエストの 1%を新しいバージョンにプロキシします。

- D. 同じプロジェクトで新しい Google App Engineアプリケーションを作成し、アプリケーションに新しいバージョンをデプロイします。トラフィックの 1%をその新しいアプリケーションに送信するようにネットワーク ロードバランサを構成します。

Correct Answer: C

Reference contents:

– TCP / UDP 負荷分散の構成 | Kubernetes Engine ドキュメント | Google Cloud

QUESTION 7

マネージド インスタンス グループとしてデプロイされた Web アプリケーションがあります。

アプリケーションの新バージョンを徐々にデプロイし、Web アプリケーションは現在ライブの Web トラフィックを受信しています。デプロイ中に利用可能な容量が減少しないようにしたいと思います。

どうするべきでしょうか?

- A. maxSurgeを 0 に設定、maxUnavailable を 1 に設定して rolling アクションの start-update を実行します。

- B. maxSurgeを 1 に設定、maxUnavailable を 0 に設定して rolling アクションの start-update を実行します。

- C. 更新されたインスタンス テンプレートを使用して新しいマネージド インスタンス グループを作成します。グループをロードバランサのバックエンドサービスに追加します。新しいマネージド インスタンス グループの全インスタンスを正常化後、古いマネージド インスタンス グループを削除します。

- D. 新しいアプリケーション バージョンで新しいインスタンス テンプレートを作成します。既存のマネージド インスタンス グループを新しいインスタンス テンプレートで更新します。マネージド インスタンス グループ内のインスタンスを削除し、マネージド インスタンス グループが新しいインスタンス テンプレートを使用してインスタンスを再作成できるようにします。

Correct Answer: B

Reference contents:

– #オフライン上限 – MIG で VM 構成の更新を自動的に適用する | Compute Engine ドキュメント | Google Cloud

QUESTION 8

ユーザーからのリレーショナルデータを保存するアプリケーションを構築しています。

世界中のユーザーがこのアプリケーションを使用します。ユーザーベースのサイズが不明なため、CTO はスケーリング要件について懸念しています。最小限の構成変更でユーザーの成長に合わせて拡張できるデータベース ソリューションを実装する必要があります。

どのストレージ ソリューションを使用するべきでしょうか?

- A. Google Cloud SQL

- B. Google Cloud Spanner

- C. Google Cloud Firestore

- D. Google Cloud Datastore

Correct Answer: B

QUESTION 9

会社の請求管理者を担当しています。

エンジニアリング チームには組織でのプロジェクト作成者の役割があります。エンジニアリングチームがプロジェクトを請求先アカウントにリンクできるようにしたくありません。プロジェクトを請求先アカウントにリンクできるのは財務チームだけですが、プロジェクトに他の変更を加えることはできません。

どうするべきでしょうか?

- A. 財務チームに請求先アカウントの請求先アカウント ユーザーの役割を割り当てます。

- B. エンジニアリング チームに請求先アカウントの請求先アカウント ユーザーの役割を割り当てます。

- C. 財務チームに請求先アカウントの請求先アカウント ユーザーの役割と組織のプロジェクト請求マネージャーの役割を割り当てます。

- D. エンジニアリング チームに請求先アカウントの請求先アカウント ユーザーの役割と組織のプロジェクト請求マネージャーの役割を割り当てます。

Correct Answer: C

Reference contents:

– Cloud Billing のアクセス制御の概要 | Google Cloud

QUESTION 10

クラスタの自動スケーリングが有効になっている GoogleKubernetes Engine (GKE) で実行されているアプリケーションがあります。

アプリケーションは TCP エンドポイントを公開しており、このアプリケーションのレプリカがいくつかあります。同じリージョンに Google Compute Engine インスタンスがありますが gce-network と呼ばれる別の仮想プライベートクラウド(VPC)にあり、最初の VPC と重複する IP 範囲はありません。このインスタンスを GKE 上のアプリケーションに接続する必要がありますが、最小限の手順にしたいと考えています。

どうするべきでしょうか?

- A.

- 1. GKE でアプリケーションのポッドをバックエンドとして使用するタイプのロードバランサを作成します。

- 2. サービスの外部トラフィック ポリシーをクラスタに設定します。

- 3. 作成されたロードバランサのアドレスを使用するように Google Compute Engine インスタンスを構成します。

- B.

- 1. GKEで、アプリケーションのポッドをバックエンドとして使用する NodePort タイプのサービスを作成します。

- 2. 各 VPC に 1つずつ、2つのネットワーク インターフェースを備えたプロキシと呼ばれる Google Compute Engine インスタンスを作成します。

- 3. このインスタンスで iptables を使用してトラフィックを gce-network から GKE ノードに転送します。

- 4. gce-network のプロキシのアドレスをエンドポイントとして使用するように Google Compute Engine インスタンスを構成します。

- C.

- 1. GKE でアプリケーションのポッドをバックエンドとして使用するタイプ LoadBalancer サービスを作成します。

- 2. このサービスにアノテーションを追加します:cloud.google.com/load-balancer-type: Internal

- 3. 2つの VPC を一緒にピアリングします。

- 4. 作成されたロードバランサのアドレスを使用するように Google Compute Engine インスタンスを構成します。

- D.

- 1. GKE でアプリケーションのポッドをバックエンドとして使用するタイプのロードバランサを作成します。

- 2. MIG のインスタンスの内部 IP をホワイトリストに登録する Google Cloud Armor のセキュリティ ポリシーをロードバランサに追加します。

- 3. 作成されたロードバランサのアドレスを使用するように Google Compute Engine インスタンスを構成します。

Correct Answer: C

Reference contents:

– 内部 TCP / UDP ロードバランサの使用 | Kubernetes Engine ドキュメント | Google Cloud

– TCP / UDP 負荷分散の構成 | Kubernetes Engine ドキュメント | Google Cloud

QUESTION 11

組織は監査ログファイルを 3年間保存する必要がある金融会社です。

この組織には数百の Google Cloud プロジェクトがあります。ログファイル保持のための費用対効果の高いアプローチを導入する必要があります。

どうするべきでしょうか?

- A. Cloud Audit から BigQuery にログを保存するシンクへのエクスポートを作成します。

- B. Cloud Audit から Coldline Storage バケットにログを保存するシンクへのエクスポートを作成します。

- C. Logging API を使用して Stackdriver ログから BigQuery にログをコピーするカスタムスクリプトを記述します。

- D. ログを Google Cloud Pub/Sub にエクスポートし、Google Cloud Dataflow パイプラインを作成してログを Google Cloud SQL に保存します。

Correct Answer: B

Reference contents:

– BigQuery のストレージを最適化する | Google Cloud

– #選択できる宛先 – ログ ルーティングの概要 | Cloud Logging

QUESTION 12

遅延の影響を受けやすい Web サイトのために GCP で単一のキャッシュ型 HTTP リバースプロキシーを実行したいとします。

この特定のリバースプロキシはほとんど CPU を消費しません。30 GBのインメモリ キャッシュを搭載し、残りのプロセス用にさらに 2 GBのメモリが必要です。

コストを最小限におさえるにはリバースプロキシはどのように動作させるべきでしょうか?

- A. 32 GBの容量を持つ Redis インスタンス用の Cloud Memorystore を作成します。

- B. Google Compute Engine で実行し、6つの vCPU と 32 GBのメモリを備えたカスタム インスタンスタイプを選択します。

- C. コンテナ イメージにパッケージ化し、インスタンス n1-standard-32 をノードとして使用して Google Kubernetes Engine で実行します。

- D. Google Compute Engine で実行し、インスタンスタイプ n1-standard-1 を選択して 32 GB の SSD 永続ディスクを追加します。

Correct Answer: A

QUESTION 13

自社のデータセンターのベアメタル サーバーでアプリケーションをホストしています。

アプリケーションは Google Cloud Storage にアクセスする必要があります。しかし、セキュリティポリシーにより アプリケーションをホストしているサーバーがパブリック IP アドレスを使用したり、インターネットにアクセスしたりすることはできません。Google のベスト プラクティスに従ってアプリケーションに Google Cloud Storage へのアクセスを提供する必要があります。

どうするべきでしょうか?

- A.

- 1. nslookup を使って storage.googleapis.com の IP アドレスを取得します。

- 2. セキュリティチームと交渉してサーバーにパブリック IP アドレスを付与できるようにします。

- 3. サーバーから storage.googleapis.com の IP アドレスへの egress トラフィックのみを許可します。

- B.

- 1. Cloud VPN を使用して Google Cloud の仮想プライベートクラウド(VPC)への VPN トンネルを作成します。

- 2. VPC で Google Compute Engine インスタンスを作成し、インスタンスに Squid プロキシサーバーをインストールします。

- 3. インスタンスを Google Cloud Storage にアクセスするためのプロキシとして使用するようにサーバーを構成します。

- C.

- 1. Migrate for Google Compute Engine(旧称 Velostrata)を使用してサーバーを Google Compute Engine に移行します。

- 2. storage.googleapis.com をバックエンドとして使用する内部ロードバランサー(ILB)を作成します。

- 3. ILB をプロキシとして使用するように新しいインスタンスを構成します。

- D.

- 1. Cloud VPN または Interconnect を使用して Google Cloud で VPC へのトンネルを作成します。

- 2. Cloud Router を使用して 199.36.153.4/30 のカスタムルート アドバタイズメントを作成します。VPN トンネルを介してオンプレミス ネットワークにネットワークをアナウンスします。

- 3.オンプレミスネットワークで *.googleapis.com を CNAME として restricted.googleapis.com に解決するように DNS サーバーを設定します。

Correct Answer: D

Reference contents:

– オンプレミス ホスト用の限定公開の Google アクセスの構成 | VPC

QUESTION 14

Google Cloud Pub/Sub トピックからのメッセージを処理するアプリケーションを Google Cloud Run にデプロイします。

Google が推奨するベスト プラクティスに従うにはどうするべきでしょうか?

- A.

- 1.トピックで Google Cloud Pub/Sub トリガーを使用して Google Cloud Functions を作成します。

- 2.すべてのメッセージに対して Google Cloud Functions から Google Cloud Run でアプリケーションを呼び出します。

- B.

- 1. Google Cloud Run で使用されるサービス アカウントに Pub / Sub サブスクライバーの役割を付与します。

- 2. トピックの Google Cloud Pub / Sub サブスクリプションを作成します。

- 3. アプリケーションにそのサブスクリプションからメッセージを Pull させます。

- C.

- 1. サービス アカウントを作成します。

- 2. Google Cloud Run アプリケーションのサービス アカウントに Google Cloud RunInvoker の役割を付与します。

- 3.サービス アカウントを使用して Google Cloud Run アプリケーションを Push エンドポイントとして使用する Google Cloud Pub/Sub サブスクリプションを作成します。

- D.

- 1. 接続を内部に設定して GKE で実行する Google Cloud にアプリケーションをデプロイします。

- 2. トピックの Google Cloud Pub/Sub サブスクリプションを作成します。

- 3. アプリケーションと同じ Google Kubernetes Engine クラスタにメッセージを受け取ってアプリケーションに送信するコンテナをデプロイします。

Correct Answer: C

Reference contents:

– #Pub/Sub との統合 – Cloud Run チュートリアルで Pub/Sub を使用する | Cloud Run のドキュメント | Google Cloud

QUESTION 15

コンテナ イメージにパッケージ化されたアプリケーションを新しいプロジェクトにデプロイする必要があります。

アプリケーションは HTTP エンドポイントを公開し、1日あたりのリクエストをほとんど受信しません。

コストを最小限に抑えるにはどうするべきでしょうか?

- A. コンテナを Google Cloud Run にデプロイします。

- B. GKE で実行される Google Cloud Run にコンテナをデプロイします。

- C. コンテナを Google App Engine Flexible にデプロイします。

- D. クラスタ オートスケーラーと水平ポッド自動スケーリングを有効にし、GKE にコンテナをデプロイします。

Correct Answer: A

QUESTION 16

会社には数百のプロジェクトと請求先アカウントを持つ既存の GCP 組織があります。

最近、買収した会社も数百のプロジェクトと独自の課金アカウントがあり、両方の GCP 組織のすべての GCP コストを1つの請求書にまとめたいと考えています。

すべてのコストを統合するにはどうするべきでしょうか?

- A. 買収した会社のプロジェクトを会社の請求先アカウントにリンクします。

- B. 買収した会社の請求先アカウントと会社の請求先アカウントを設定し、請求データを同じ BigQuery データセットにエクスポートします。

- C. 買収した会社のプロジェクトを会社の GCP 組織に移行します。移行したプロジェクトを会社の請求先アカウントにリンクします。

- D. 新しい GCP 組織と新しい請求先アカウントを作成します。買収した会社のプロジェクトと会社のプロジェクトを新しい GCP 組織に移行し、プロジェクトを新しい請求先アカウントにリンクします。

Correct Answer: A

Reference contents:

– Google Cloud Platform Cross Org Billing | by Ferris Argyle | Medium

QUESTION 17

Google Cloud Spanner を使用するアプリケーションを GoogleCloud に構築しました。

サポートチームは環境を監視する必要があり、テーブルデータにアクセスできないようにする必要があります。サポートチームに適切な権限を付与するための合理化されたソリューションが必要で Google のベスト プラクティスに従います。

どうするべきでしょうか?

- A. サポートチーム グループに monitoring.viewer の役割を追加します。

- B. サポートチーム グループに spanner.databaseUser の役割を追加します。

- C. サポートチーム グループに spanner.databaseReader の役割を追加します。

- D. サポートチーム グループに stackdriver.accounts.viewer の役割を追加します。

Correct Answer: A

Reference contents:

– ロールについて | IAM ドキュメント | Google Cloud

QUESTION 18

分析のために、すべての Google Compute Engine インスタンスからのすべてのログを platform-logs と呼ばれる BigQuery データセットに送信する必要があります。

すでにすべてのインスタンスに Google Cloud Logging エージェントがインストールされています。

コストを最小限に抑えるにはどうするべきでしょうか?

- A.

- 1. インスタンスで使用しているサービス アカウントに platform-logs データセットの BigQuery Data Editor の役割を付与します。インスタンスのメタデータを更新して logs-destination: bq://platform-logs の値を追加します。

- 2. インスタンスのメタデータを更新して logs-destination: bq://platform-logs. の値を追加します。

- B.

- 1. Google Cloud Logging で logs という Google Cloud Pub/Sub トピックをシンクとして logs エクスポートを作成します。

- 2. logs トピックのメッセージによってトリガーされる Google Cloud Functions を作成します。

- 3. Google Cloud Functions を構成して Google Compute Engine からのものではないログを削除し、Google Compute Engine ログを platform-logs データセットに挿入します。

- C.

- 1. Google Cloud Loggingで、Google ComputeEngineログのみを表示するフィルタを作成します。

- 2. [エクスポートの作成]をクリックします。

- 3. シンク サービスとして BigQuery を選択し、シンク宛先として platform-logs データセットを選択します。

- D.

- 1. platform-logs データセットで BigQuery ユーザーの役割を持つ Google Cloud Functions を作成します。

- 2. クエリを実行する BigQuery ジョブを作成するように Google Cloud Functions を構成します。INSERTINTOdataset.platform-logs(timestamp、log)SELECTtimestamp、log FROMcompute.logs WHEREtimestamp> DATE_SUB(CURRENT_DATE()、INTERVAL 1 DAY)

- 3. Google Cloud Scheduler を使用して Google Cloud Functions を1日1回トリガーします。

Correct Answer: C

Reference contents:

– シンクを構成して管理する | Cloud Logging

QUESTION 19

Google Cloud Deployment Manager を使用して Google Kubernetes Engine クラスタを作成しています。

同じ Google Cloud Deployment Manager デプロイメントを使用してクラスタの kube-system 名前空間に DaemonSet を作成する必要があります。可能な限り少ないサービスを使用するソリューションが必要です。

どうするべきでしょうか?

- A. クラスタ API を Google Cloud Deployment Manager の新しいタイプ プロバイダとして追加し、新しいタイプを使用して DaemonSet を作成します。

- B. Google Cloud Runtime Configuration API を使用して DaemonSet 定義を含む新しい Config リソースを作成します。

- C. Google Cloud Deployment Manager の kubectl を使用して DaemonSet を作成する起動スクリプトを使用し、Google Compute Engine インスタンスを作成します。

- D. Google Cloud Deployment Manager のクラスタ定義で kube-system をキーとし、DaemonSet マニフェストを値として持つメタデータを追加します。

Correct Answer: A

Reference contents:

– API をタイプ プロバイダとして追加 | Cloud Deployment Manager のドキュメント | Google Cloud

– Cloud Deployment Manager & Kubernetes | by Daz Wilkin | Google Cloud – Community | Medium

QUESTION 20

データセンターで実行されるアプリケーションを構築しています。

アプリケーションは Cloud AutoML などの Google Cloud Platform(GCP)サービスを使用します。Cloud AutoML に適切にアクセスできるサービス アカウントを作成しました。オンプレミス環境から API への認証を有効にする必要があります。

どうするべきでしょうか?

- A. オンプレミスのアプリケーションでサービス アカウントの認証情報を使用します。

- B. gcloud を使用して適切な権限を持つサービス アカウントのキーファイルを作成します。

- C. 顧客のデータセンターと Google Cloud Platform の間に直接相互接続を設定し、オンプレミス アプリケーションの認証を可能にします。

- D. IAM & 管理コンソールにアクセスしてサービス アカウントと同様の権限をユーザーアカウントに付与し、データセンターからの認証にこのユーザーアカウントを使用します。

Correct Answer: B

Reference contents:

– 始める前に | AutoML Vision | Google Cloud

QUESTION 21

Google Container Registry を使用して自社のコンテナ イメージを別プロジェクトで一元保管しています。

別のプロジェクトで Google Kubernetes Engine(GKE)クラスタを作成し、Kubernetes が Google Container Registry からイメージをダウンロードできるようにしたいと考えています。

どうするべきでしょうか?

- A. 画像が保存されているプロジェクトで Kubernetes ノードが使用するサービス アカウントに Storage ObjectViewerIAM の役割を付与します。

- B. GKE クラスタを作成する際に [アクセススコープ] から [すべての Cloud API へのフルアクセスを許可する] オプションを選択します。

- C. サービス アカウントを作成し、Google Cloud Storage にアクセスできるようにします。このサービス アカウントの P12 キーを作成して Kubernetes の imagePullSecrets として使用します。

- D. Google Cloud Storage の各イメージに ACL を設定し、デフォルトの Google Compute Engine サービス アカウントへの読み取り専用アクセスを許可します。

Correct Answer: A

Reference contents:

– IAM を使用したアクセス制御 | Container Registry ドキュメント | Google Cloud

– #事前定義ロール – Cloud Storage に適用される IAM のロール | Google Cloud

– #レジストリからイメージを pull する – イメージの push と pull | Container Registry ドキュメント | Google Cloud

QUESTION 22

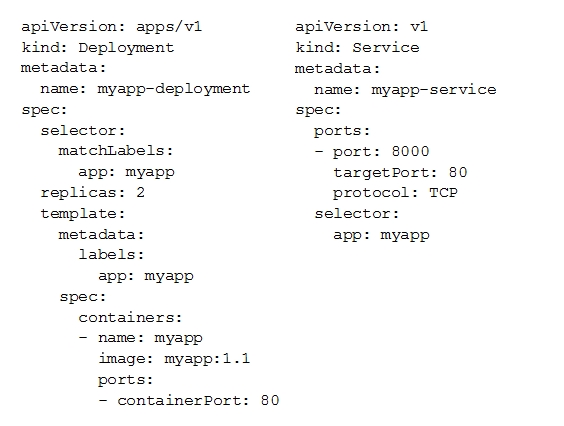

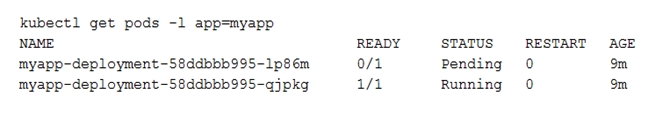

以下の YAML ファイルを使用して Google Kubernetes Engine クラスタ内に新しいアプリケーションをデプロイしました。

デプロイされたポッドの状態を確認するとそのうちの 1つがまだ PENDING の状態であることに気づきました。

そのポッドがなぜ PENDING 状態になっているのかを調べたいと思います。

どうするべきでしょうか?

- A. myapp-service サービスオブジェクトの詳細を確認し、エラーメッセージを確認します。

- B. myapp-deployment Deployment オブジェクトの詳細を確認し、エラーメッセージを確認します。

- C. myapp-deployment-58ddbbb995-lp86m ポッドの詳細を確認し、警告メッセージを確認します。

- D. myapp-deployment-58ddbbb995-lp86m ポッドのコンテナのログを表示し、警告メッセージを確認します。

Correct Answer: C

Reference contents:

– Troubleshoot Applications | Kubernetes

QUESTION 23

Google Compute Engine で Windows VM をセットアップし、RDP 経由で VM にログインできることを確認します。

どうするべきでしょうか?

- A. VM の作成後、Google アカウントの認証情報を使用して VM にログインします。

- B. VM の作成後、gcloud compute reset-windows-password を使用して VM のログイン認証情報を取得します。

- C. VMの作成時に windows-password をキー、パスワードを値としてインスタンスにメタデータを追加します。

- D. VM の作成後、Google Compute Engine のデフォルトのサービス アカウント用の JSON 秘密鍵をダウンロードします。JSON ファイルの認証情報を使用して VM にログインします。

Correct Answer: B

Reference contents:

– gcloud beta compute reset-windows-password | Google Cloud CLI Documentation

– Windows VM の認証情報を生成する | Compute Engine ドキュメント | Google Cloud

QUESTION 24

dev1 グループのユーザーに対して、単一の Google Compute Engine インスタンスへの SSH 接続を構成する必要があります。

このインスタンスはこの特定の Google Cloud Platform プロジェクトで dev1 ユーザーが接続できる必要がある唯一のリソースです。

どうするべきでしょうか?

- A. インスタンスのメタデータを enable-oslogin=true に設定します。dev1 グループに compute.osLogin の役割を付与します。Google Cloud Shell を使用してそのインスタンスに SSH するように指示します。

- B. インスタンスのメタデータを enable-oslogin=true に設定します。そのインスタンスのサービス アカウントを no に設定します。Google Cloud Shell を使用してそのインスタンスに SSH するように指示します。

- C. インスタンスのブロック プロジェクト全体のキーを有効にします。dev1 グループのユーザーごとに SSH キーを生成します。キーを dev1 ユーザーに配布し、サードパーティ ツールを使用して接続するようにユーザーに指示します。

- D. インスタンスのブロック プロジェクト全体のキーを有効にします。SSH キーを生成し、そのキーをそのインスタンスに関連付けます。キーを dev1 ユーザーに配布し、サードパーティ ツールを使用して接続するようにユーザーに指示します。

Correct Answer: A

Reference contents:

– #OS ログインの IAM 役割を付与する – OS Login の設定 | Compute Engine ドキュメント | Google Cloud

– 高度な方法による Linux VM への接続 | Compute Engine ドキュメント | Google Cloud

QUESTION 25

Google Cloud Shell の gcloud コマンドラインを使用して GCP プロジェクトで有効になっている Google Cloud Platform API のリストを作成する必要があります。

プロジェクト名は my-project です。

どうするべきでしょうか?

- A. gcloud projects list を実行して プロジェクトID を取得し、gcloud services list –project <project ID> を実行します。

- B. gcloud init を実行して現在のプロジェクトを my-project に設定し、gcloud services list –available を実行します。

- C. gcloud info を実行してアカウント値を表示し、gcloud services list –account <Account> を実行します。

- D. gcloud projects describe <project ID> を実行してプロジェクトの値を確認した後、gcloud services list –available を実行します。

Correct Answer: A

Reference contents:

– gcloud services list | Google Cloud CLI Documentation

QUESTION 26

Google App Engine 環境でホストされているアプリケーションの新バージョンを構築しています。

アプリケーションを完全に新しいバージョンに切り替える前に 1%のユーザーで新しいバージョンをテストしたいと考えています。

どうするべきでしょうか?

- A. Google App Engine の代わりにGoogle Kubernetes Engine にアプリケーションの新バージョンをデプロイし、Google Cloud Console を使ってトラフィックを分割します。

- B. Google App Engine の代わりにGoogle Compute Engine インスタンスにアプリケーションの新バージョンをデプロイし、Google Cloud Console を使ってトラフィックを分割します。

- C. 新しいバージョンを別のアプリとして Google App Engine にデプロイします。次に Google Cloud Console を使用して 2つのアプリ間でトラフィックを分割するように Google App Engine を設定します。

- D. Google App Engine に新しいバージョンのアプリケーションをデプロイします。その後、Google Cloud Console の Google App Engine の設定で現在のバージョンと新しくデプロイされたバージョンの間でトラフィックを分割します。

Correct Answer: D

Reference contents:

– App Engine アプリケーション プラットフォーム | Google Cloud

QUESTION 27

GCP pricing calculator for Kubernetes を使用して Kubernetes クラスタのコスト見積もりを行います。

ワークロードは高い IOPs を必要とし、ディスク スナップショットも使用する予定です。最初に、ノード数、平均時間、平均日数を入力します。

どうするべきでしょうか?

- A. ローカル SSD を入力します。永続ディスクストレージとスナップショット ストレージを入力します。

- B. ローカル SSD を入力します。クラスタ管理費用の見積もりを追加します。

- C. [ GPU の追加] を選択します。永続ディスク ストレージとスナップショット ストレージを入力します。

- D. [ GPU の追加] を選択します。クラスタ管理費用の見積もりを追加します。

Correct Answer: A

Reference contents:

– ローカル SSD について | Compute Engine ドキュメント | Google Cloud

QUESTION 28

自動スケーリングを有効にして Google Kubernetes Engine を使用して新しいアプリケーションをホストしています。

パブリック IP アドレスで HTTPS を使用して新しいアプリケーションを公開したいと思います。

どうするべきでしょうか?

- A. アプリケーション用に NodePort タイプの Kubernetes サービスを作成し、Kubernetes Ingress を作成して Cloud Load Balancing を介してこのサービスを公開します。

- B. アプリケーション用に ClusterIP タイプ の Kubernetes サービスを作成します。このサービスの IP を使用してアプリケーションのパブリック DNS 名を構成します。

- C. NodePort タイプ の Kubernetes サービスを作成して Kubernetes クラスタの各ノードのポート 443 でアプリケーションを公開します。負荷分散を実現するにはクラスタのすべてのノードの IP を使用してアプリケーションのパブリック DNS 名を構成します。

- D. クラスタ内に HAProxy ポッドを作成してアプリケーションのすべてのポッドへのトラフィックを負荷分散します。iptables ルールを使用してパブリックトラフィックを HAProxy に転送します。HAProxy が実行されているノードのパブリック IP を使用してアプリケーションの DNS 名を構成します。

Correct Answer: A

Reference contents:

– Ingress による HTTP(S) 負荷分散の設定 | Kubernetes Engine | Google Cloud

– Service | Kubernetes

QUESTION 29

現在 2つの異なる GCP プロジェクトを実行している Google Compute Engine インスタンスの複数のグループ間のトラフィックを有効にする必要があります。

Google Compute Engine インスタンスの各グループは独自の VPC で実行されています。

どうするべきでしょうか?

- A. 両方のプロジェクトが GCP 組織に属していることを確認します。新しい VPC を作成してすべてのインスタンスを追加します。

- B. 両方のプロジェクトが GCP 組織に属していることを確認します。一方のプロジェクトから VPC を共有し、もう一方のプロジェクトの Google Compute Engine インスタンスが共有 VPC を使用するように要求します。

- C. 両方のプロジェクトのプロジェクト管理者であることを確認します。2つの新しい VPC を作成し、すべてのインスタンスを追加します。

- D. 両方のプロジェクトのプロジェクト管理者であることを確認します。新しい VPC を作成し、すべてのインスタンスを追加します。

Correct Answer: B

Reference contents:

– 共有 VPC の概要 | Google Cloud

QUESTION 30

Google Cloud Platform プロジェクトに新しい監査人を追加したいと思います。

監査人はすべてのプロジェクトアイテムの読み取りを許可する必要がありますが、変更することはできません。

監査人の権限をどのように構成する必要がありますか?

- A. プロジェクトの閲覧のみの権限を持つカスタムロールを作成します。ユーザーのアカウントをカスタムロールに追加します。

- B. サービスの閲覧のみの権限を持つカスタムロールを作成します。ユーザーのアカウントをカスタムロールに追加します。

- C. 事前定義された IAM の project Viewer の役割を選択します。ユーザーのアカウントをこのロールに追加します。

- D. 事前定義された IAM の service Viewer の役割を選択します。ユーザーのアカウントをこのロールに追加します。

Correct Answer: C

Reference contents:

– IAM を使用したプロジェクトのアクセス制御 | Resource Manager のドキュメント | Google Cloud

QUESTION 31

会社で Google Kubernetes Engine(GKE)クラスタを運用しており、さまざまなチームが非本番ワークロードを実行できるようにしています。

機械学習(ML)チームはモデルを訓練するために Nvidia Tesla P100 GPU にアクセスする必要があります。労力とコストを最小限に抑えたいと考えています。

どうするべきでしょうか?

- A. ML チームにポッド仕様にアクセラレータ:gpu アノテーションを追加するように依頼します。

- B. GKE クラスタの全ノードを再作成し、すべてのノードで GPU を有効にします。

- C. Google Compute Engine に GPU を搭載したノードで独自の Kubernetes クラスタを作成します。このクラスタを ML チームに割り当てます。

- D. GKE クラスタに新しい GPU 対応のノードプールを追加します。ML チームに cloud.google.com/gke -accelerator: nvidia-tesla-p100 nodeSelector をポッド仕様に追加するよう依頼します。

Correct Answer: D

Reference contents:

– GPU の実行 | Kubernetes Engine ドキュメント | Google Cloud

QUESTION 32

VM はサブネットマスクが 255.255.255.240 のサブネットで実行されています。

現在のサブネットにはこれ以上空いている IP アドレスがなく、新しい VM のためにさらに 10個の IP アドレスが必要です。既存の VM と新しい VM はすべて追加のルートなしで互いに到達できる必要があります。

どうするべきでしょうか?

- A. gcloud を使用して現在のサブネットの IP 範囲を拡張します。

- B. サブネットを削除し、より広い範囲の IP アドレスを使用して再作成します。

- C. 新しいプロジェクトを作成します。共有 VPC を使用して現在のネットワークを新しいプロジェクトと共有します。

- D. 現在のサブネットを上書きするために同じ開始 IP でより広い範囲を持つ新しいサブネットを作成します。

Correct Answer: A

Reference contents:

– gcloud compute networks subnets expand-ip-range | Google Cloud CLI Documentation

QUESTION 33

顧客の組織ではコミュニケーションとコラボレーションに G Suite を使用しています。

組織内のすべてのユーザーは G Suite アカウントを持っています。一部の G Suite ユーザーに Google Cloud Platform プロジェクトへのアクセス権を付与したいと思います。

どうするべきでしょうか?

- A. ドメインの Google Cloud Console で Cloud Identity を有効化します。

- B. G Suite のメールアドレスを使用して必要な IAM ロールを付与します。

- C. 全ユーザーのメールアドレスが記載された CSV シートを作成します。gcloud コマンドラインツールを使って Google Cloud Platform アカウントに変換します。

- D. G Suite コンソールでユーザーを cloud-console-users@yourdomain.com という特別なグループに追加します。Google Cloud Platform のデフォルトの動作に依存してユーザーがこのグループのメンバーである場合にアクセスを許可します。

Correct Answer: B

Reference contents:

– 組織の作成と管理 | Resource Manager ドキュメント | Google Cloud

QUESTION 34

本番プロジェクトと開発プロジェクトの両方にアクセスできる Google Cloud Platform アカウントがあります。

自動化されたプロセスを作成し、開発プロジェクトと本番プロジェクトのすべてのコンピューティング インスタンスを毎日一覧表示する必要があります。

どうするべきでしょうか?

- A. gcloud config を使用して 2つの設定を作成します。構成を個別にアクティブとして設定するスクリプトを記述します。設定ごとに gcloud Compute Instances List を使用してコンピューティング リソースのリストを取得します。

- B. gsutil config を使用して 2つの構成を作成します。構成を個別にアクティブとして設定するスクリプトを記述します。構成ごとに gsutil compute instances list を使用してコンピュート リソースのリストを取得します。

- C. Google Cloud Shell にアクセスして情報を Google Cloud Storage に日次でエクスポートします。

- D. Google Cloud Console にアクセスして情報を Google Cloud SQL に日次でエクスポートします。

Correct Answer: A

Reference contents:

– gcloud compute instances list | Google Cloud CLI Documentation

QUESTION 35

Google Cloud Storage バケットに 5 TB の大きな AVRO ファイルが保存されています。

アナリストは SQL に精通しており、このファイルに保存されているデータにアクセスする必要があります。できるだけ早く彼らの要求を完了するために費用対効果の高い方法を見つけなければなりません。

どうするべきでしょうか?

- A. Google Cloud Datastoreにデータを読み込み、それに対して SQL クエリを実行します。

- B. BigQuery のテーブルを作成し、BigQuery でデータを読み込みます。このテーブルで SQL クエリを実行し、リクエストが完了したらこのテーブルを削除します。

- C. BigQuery で Google Cloud Storage バケットを指す外部テーブルを作成し、これらの外部テーブルで SQL クエリを実行してリクエストを完了させます。

- D. Hadoop クラスタを作成し、AVRO ファイルを圧縮して NDFS にコピーします。hive テーブルにファイルをロードし、アナリストが SQL クエリを実行できるようにアクセス権を付与します。

Correct Answer: C

Reference contents:

– 外部データソースの概要 | BigQuery | Google Cloud

– Cloud Storage データのクエリ | BigQuery | Google Cloud

– #Avro スキーマ – Cloud Storage からの Avro データの読み込み | BigQuery | Google Cloud

QUESTION 36

Google Cloud Platform のサービス アカウントが特定の時刻に作成されたことを確認する必要があります。

どうするべきでしょうか?

- A. アクティビティ ログをフィルタリングして構成カテゴリを表示します。リソースタイプをサービス アカウントにフィルタリングします。

- B. アクティビティ ログをフィルタリングして構成カテゴリを表示します。リソースタイプを Google プロジェクトにフィルタリングします。

- C. アクティビティ ログをフィルタリングしてデータアクセスカテゴリを表示します。リソースタイプをサービス アカウントにフィルタリングします。

- D. アクティビティ ログをフィルタリングしてデータアクセスカテゴリを表示します。リソースタイプを Google プロジェクトにフィルタリングします。

Correct Answer: A

QUESTION 37

UDP を使用してポート 636 を介して TLS 経由で到達可能な LDAP サーバーを Google Compute Engine にデプロイしました。

そのポートを介してクライアントから到達可能であることを確認したいと考えています。

どうするべきでしょうか?

- A. LDAP サーバーを実行している VM インスタンスにネットワーク タグ allow-udp-636 を追加します。

- B. allow-udp-636 というルートを作成し、ネクストホップを LDAP サーバーを実行している VM インスタンスに設定します。

- C. 選択したネットワーク タグをインスタンスに追加します。そのネットワーク タグの UDP ポート 636 での上り(内向き)を許可するファイアウォール ルールを作成します。

- D. LDAP サーバーを実行しているインスタンスに選択したネットワーク タグを追加します。そのネットワーク タグの UDP ポート 636 での下り(外向き)を許可するファイアウォール ルールを作成します。

Correct Answer: C

QUESTION 38

管理している 3つの Google Cloud Platform プロジェクトのいずれかで Google Compute Engineer サービスを使用するための予算アラートを設定する必要があります。

3つのプロジェクトはすべて 1つの課金アカウントにリンクされています。

どうするべきでしょうか?

- A. プロジェクトの課金管理者であることを確認します。関連する請求先アカウントを選択し、適切なプロジェクトの予算とアラートを作成します。

- B. プロジェクトの課金管理者であることを確認します。関連する請求先アカウントを選択し、予算とカスタムアラートを作成します。

- C. プロジェクト管理者であることを確認します。関連する請求先アカウントを選択し、適切なプロジェクトの予算を作成します。

- D. プロジェクト管理者であることを確認します。関連する請求先アカウントを選択し、予算とカスタムアラートを作成します。

Correct Answer: A

Reference contents:

– ロールについて | IAM のドキュメント | Google Cloud

QUESTION 39

タスクを実行するために 96個の vCPU を必要とする本番環境に不可欠なオンプレミス アプリケーションを移行しています。

アプリケーションが GCP の同様の環境で動作されることを確認する必要があります。

どうするべきでしょうか?

- A. VM を作成するときは n1-standard-96 マシンタイプを使用します。

- B. VMを作成するときは CPU プラットフォームとして IntelSkylake を使用してください。

- C. Google Compute Engine のデフォルト設定を使用して VM を作成します。gcloud を使用して実行中のインスタンスを変更し、96個の vCPU を使用します。

- D. Google Compute Engine のデフォルト設定を使用して VM を起動し、適正化の推奨事項に基づいて調整します。

Correct Answer: A

QUESTION 40

Google Cloud Storage バケットにデータをアーカイブするためのソリューションを構成する必要があります。

ソリューションは費用効果が高く、複数のバージョンのデータは 30日後にアーカイブする必要があります。以前のバージョンはレポートのために月に 1回アクセスされます。このアーカイブデータも月末に更新されることがあります。

どうするべきでしょうか?

- A. 30日後に新しいバージョンのデータを Coldline Storage にアーカイブするバケットのライフサイクル管理を追加します。

- B. 30日後に新しいバージョンのデータを Nearline Storage にアーカイブするバケットのライフサイクル管理を追加します。

- C. 30日後に Regional Storage から Coldline Storage にデータをアーカイブするバケットのライフサイクル管理を追加します。

- D. 30日後に Regional Storage から Nearline Storage にデータをアーカイブするバケットのライフサイクル管理を追加します。

Correct Answer: B

Reference contents:

– オブジェクト ライフサイクルを管理する | Cloud Storage

– #NumberOfNewerVersions – オブジェクトのライフサイクル管理 | Cloud Storage | Google Cloud

QUESTION 41

会社のインフラはオンプレミスですべてのマシンは最大容量で稼働しています。

Google Cloud にバーストしたいと考えています Google Cloud のワークロードはプライベート IP 範囲を使用してオンプレミスのワークロードと直接通信できる必要があります。

どうするべきでしょうか?

- A. Google Cloud で共有 VPC のホストとして VPC を設定します。

- B. Google Cloud で VPC ネットワーク ピアリング用に VPC を設定します。

- C. オンプレミス環境と Google Cloud の両方で踏み台インスタンスを作成します。パブリック IP アドレスを使用して両方をプロキシ サーバとして構成します。

- D. オンプレミスのインフラストラクチャと Google Cloud の間に Cloud VPN を設定します。

Correct Answer: D

Reference contents:

– Google Cloud ハイブリッド接続 | Google Cloud

QUESTION 42

Google Cloud Platform にデータを保存とアーカイブするためのソリューションを選択して構成する必要があります。

1つの地理的な場所からのデータのコンプライアンス目標をサポートする必要があり、データは 30日後にアーカイブされ、毎年アクセスする必要があります。

どうするべきでしょうか?

- A. Multi-Regional Storage を選択します。30日後にデータを Coldline Storage にアーカイブするバケットのライフサイクル管理を追加します。

- B. Multi-Regional Storage を選択します。30日後にデータを Nearline Storage にアーカイブするバケットのライフサイクル管理を追加します。

- C. Regional Storage を選択します。30日後にデータを Nearline Storage にアーカイブするバケットのライフサイクル管理を追加します。

- D. Regional Storage を選択します。30日後にデータを Coldline Storage にアーカイブするバケットのライフサイクル管理を追加します。

Correct Answer: D

Reference contents:

– ストレージ クラス | Google Cloud

QUESTION 43

会社ではデータウェアハウスに BigQuery を使用しています。

会社の多くの異なるビジネスユニットは数百のプロジェクトにわたって 1,000 以上のデータセットを作成してきました。CIO はすべてのデータセットを調査して employee_ssn カラムを含むテーブルを見つけるよう求めています。このタスクを実行するための労力を最小限に抑えたいと考えています。

どうするべきでしょうか?

- A. Data Catalog に移動し、検索ボックスで employee_ssn を検索します。

- B. bq コマンドラインツールを使用して組織内のすべてのプロジェクトをループする Shell スクリプトを記述します。

- C. 組織内のすべてのプロジェクトをループし、INFORMATION_SCHEMA.COLUMNS ビューでクエリを実行して employee_ssn 列を見つけるスクリプトを記述します。

- D. 組織内のすべてのプロジェクトをループし、INFORMATION_SCHEMA.COLUMNS ビューでクエリを実行して employee_ssn 列を見つけ、 Google Cloud Dataflow ジョブを作成します。

Correct Answer: A

QUESTION 44

単一のプリエンプティブ ノードプールを持つ Google Kubernetes Engine クラスタに 2つのレプリカを使用してデプロイを作成します。

数分後、kubectl を使用してポッドのステータスを調べ、そのうちの 1つがまだ保留中のステータスになっていることを確認します。

最も可能性の高い原因は何でしょうか?

- A. 保留中のポポッドのリソース要求は大きすぎて、クラスタの 1つのノードに収まりません。

- B. クラスタ内ですでに多くのポッドが動作しており、保留中のポッドをスケジュールするのに十分なリソースが残っていない状態です。

- C. ノードプールには保留中のポッドが使用するコンテナ イメージを引き出す権限を持たないサービス アカウントが設定されています。

- D. 保留中のポッドはもともとあるノードでスケジュールされていましたが、デプロイメントを作成してからポッドの状態を確認するまでの間に先取りされました。現在、新しいノードに再スケジュールされています。

Correct Answer: B

Reference contents:

– Kubernetes Troubleshooting Walkthrough – Pending Pods | ManagedKube

– Troubleshoot Applications | Kubernetes

QUESTION 45

Google Cloud Platform(GCP)プロジェクトでユーザーが Google Cloud Spanner Identity Access Management(IAM)の役割に追加された時期を確認する必要があります。

どうするべきでしょうか?

- A. Google Cloud Spanner コンソールを開いて、構成を確認します。

- B. IAM と管理コンソールを開き、Google Cloud Spanner の役割のIAMポリシーを確認します。

- C. Stackdriver Monitoring コンソールに移動し、Google Cloud Spanner の情報を確認します。

- D. Stackdriver Logging コンソールに移動し、管理アクティビティ ログを確認して、Google Cloud Spanner IAM ロール用にフィルタリングします。

Correct Answer: D

Reference contents:

– #管理アクティビティ監査ログ – Cloud Audit Logs の概要 | Cloud Logging | Google Cloud

QUESTION 46

会社は BigQuery をエンタープライズ データ ウェアハウスとして実装しました。

複数のビジネスユニットのユーザーがデータ ウェアハウスでクエリを実行します。ただし、BigQuery のクエリコストは非常に高いため、コストを管理する必要があります。

どちらの方法を使用する必要がありますか? (回答を 2つ選んでください)

- A. ユーザーをビジネスユニットから複数のプロジェクトに分割します。

- B. BigQuery データ ウェアハウスにユーザーレベルまたはプロジェクトレベルのカスタムクエリ クォータを適用します。

- C. ビジネスユニットごとに BigQuery データ ウェアハウスの個別のコピーを作成します。

- D. BigQuery データ ウェアハウスをビジネスユニットごとに複数のデータウェアハウスに分割します。

- E. BigQuery クエリモデルをオンデマンドから定額に変更します。各プロジェクトに適切な数のスロットを適用します。

Correct Answer: B, E

Reference contents:

– カスタムコスト管理を作成する | BigQuery | Google Cloud

– 料金 | BigQuery: クラウド データ ウェアハウス | Google Cloud

QUESTION 47

Google Kubernetes Engine(GKE)で製品を構築しています。

単一の GKE クラスタがあります。顧客ごとにポッドはそのクラスタで実行されており、顧客はポッド内で任意のコードを実行できます。顧客のポッド間の分離を最大化する必要があります。

どうするべきでしょうか?

- A. Binary Authorization を使用して顧客のポッドで使用されているコンテナ イメージのみをホワイトリストに登録します。

- B. Container Analysis API を使用して顧客のポッドで使用されているコンテナの脆弱性を検出します。

- C. gvisor に設定されたサンドボックス タイプで GKE ノードプールを作成します。パラメータ runtimeClassName: gvisor を顧客ポッドの仕様に追加します。

- D. GKE ノードには cos_containerd イメージを使用します。値 cloud.google.com/gke-os-distribution: cos_containerdのnodeSelector を顧客ポッドの仕様に追加します。

Correct Answer: C

Reference contents:

– Kubernetes – Google Kubernetes Engine(GKE) | Google Cloud

– GKE Sandbox | Kubernetes Engine ドキュメント | Google Cloud

QUESTION 48

顧客は Google Cloud Spanner を使用するソリューションを実装しており、1つのテーブルで読み取りレイテンシーに関連するパフォーマンスの問題に気づきました。

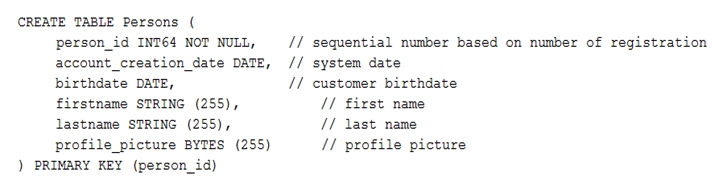

このテーブルはプライマリキーを使用して、そのユーザーのみがアクセスできます。テーブルスキーマは以下のとおりです。

問題を解決するためにはどうするべきでしょうか?

- A. テーブルから profile_picture フィールドを削除します。

- B. person_id 列にセカンダリ インデックスを追加します。

- C. 単調に増加する値を持たないようにプライマリキーを変更します。

- D. 次のデータ定義言語(DDL)を使用してセカンダリ インデックスを作成します。

CREATE INDEX person_id_ix

ON Persons (

person_id,

firstname,

lastname

) STORING (

profile_picture

)

Correct Answer: C

Reference contents:

– スキーマ設計 | Cloud Spanner | Google Cloud

– Cloud Spanner — Choosing the right primary keys | by Robert Kubis | Google Cloud – Community | Medium

QUESTION 49

ファイナンス チームはプロジェクトの請求レポートを表示したいと考えています。

ファイナンス チームがプロジェクトへの追加の権限を取得しないようにする必要があります。

どうするべきでしょうか?

- A. ファイナンス チームのグループを請求先アカウント ユーザー (roles/billing.user) の役割に追加します。

- B. ファイナンス チームのグループを請求先アカウント管理者 (roles/billing.admin) の役割に追加します。

- C. ファイナンス チームのグループを請求先アカウント閲覧者 (roles/billing.viewer) の役割に追加します。

- D. ファイナンス チームのグループをプロジェクト支払い管理者 (roles/billing.projectManager) の役割に追加します。

Correct Answer: C

Reference contents:

– Cloud Billing のアクセス制御の概要 | Google Cloud

QUESTION 50

組織には Google Cloud プロジェクトへのアクセスを制御するための厳しい要件があります。

サイト信頼性エンジニアリング(SRE)がサポートケースを開いたときに SRE が Google Cloud サポートチームからのリクエストを承認できるようにする必要があります。

Google のベスト プラクティスに従うにはどうするべきでしょうか?

- A. SRE を管理者ロール(roles/iam.roleAdmin)の役割に追加します。

- B. SRE を Access Approval 承認者 (roles/accessapproval.approver)に追加します。

- C. SRE をグループに追加し、グループを管理者ロール(roles/iam.roleAdmin)の役割に追加します。

- D. SRE をグループに追加し、グループを Access Approval 承認者 (roles/accessapproval.approver)の役割に追加します。

Correct Answer: D

![[GCP] Google Cloud Certified - Associate Cloud Engineer](https://www.cloudsmog.net/wp-content/uploads/google-cloud-certified_associate-cloud-engineer-1200x675.jpg)

Comments are closed